Your Bite-Sized Updates!

ก้าวล้ำไปในโลกเทคโนโลยีที่เปลี่ยนแปลงเร็วด้วยข้อมูลอัปเดต ตั้งแต่แกดเจ็ตล่าสุดและความก้าวหน้าของ AI หรือความปลอดภัยทางไซเบอร์และแนวโน้มของซอฟต์แวร์ เรานำเสนอข่าวสารด้านเทคโนโลยีที่สำคัญที่สุดให้กับคุณ

Google ยกระดับ AI ครั้งใหญ่ใน I/O 2025 เตรียมพลิกโฉมการใช้งานดิจิทัล

ในงานประชุมนักพัฒนา Google I/O 2025 ประจำปี Google ได้ยกให้ปัญญาประดิษฐ์ (AI) เป็นหัวใจสำคัญของงาน โดยมีการเปิดตัวการอัปเดตครั้งใหญ่ที่ผสาน AI เข้าไปในผลิตภัณฑ์หลักต่าง ๆ อย่างลึกซึ้งมากขึ้น ไม่ว่าจะเป็น Search, Gmail และ Chrome

บริษัทได้เปิดตัวโมเดล AI ที่ได้รับการพัฒนาให้มีความสามารถมากขึ้น ทั้งในด้านการสร้างภาพ การเขียนโค้ด และการทำงานอัตโนมัติ ซึ่งนับเป็นก้าวสำคัญที่ช่วยยกระดับประสบการณ์การใช้งานให้ชาญฉลาดและตอบสนองผู้ใช้ได้ดียิ่งขึ้นในระบบนิเวศของ Google

นอกจากนี้ Google ยังได้แง้มโครงการใหม่ที่ทะเยอทะยานในอนาคต เช่น การยกระดับวิดีโอคอล การพัฒนาผู้ช่วยดิจิทัลให้ฉลาดขึ้นและสนทนาได้เป็นธรรมชาติยิ่งขึ้น รวมถึงการร่วมมือกับแบรนด์แว่นตารายเดิมเพื่อสร้างแว่นตาอัจฉริยะรุ่นใหม่

แม้ว่า Android จะไม่ได้รับความสนใจเป็นพิเศษในงาน Keynote หลัก แต่ Google ก็ได้ประกาศอัปเดตต่าง ๆ ไปแล้วก่อนหน้านี้ในสัปดาห์เดียวกัน ซึ่งรวมถึงการออกแบบใหม่ของระบบปฏิบัติการบนมือถือ และการปรับปรุงระบบติดตามอุปกรณ์ให้ดีขึ้น

‘https://www.theverge.com/google/670224/google-io-2025-live-blog-gemini

การพัฒนา AI แบบ ‘คิดเหตุผล’ อาจชะลอตัวเร็วๆ นี้

สถาบันวิจัย AI ที่ไม่แสวงหาผลกำไร Epoch AI ได้ออกรายงานวิเคราะห์ระบุว่า อุตสาหกรรม AI อาจไม่สามารถสร้างประสิทธิภาพที่เพิ่มขึ้นอย่างมหาศาลจากโมเดล AI ประเภท “คิดเหตุผล” (reasoning models) ได้นานมากนักแล้ว โดยความคืบหน้าอาจชะลอตัวลงภายในหนึ่งปีข้างหน้า โมเดล reasoning อย่าง o3 ของ OpenAI แสดงผลการปรับปรุงที่น่าประทับใจในการทดสอบ AI โดยเฉพาะด้านคณิตศาสตร์และการเขียนโปรแกรม โมเดลเหล่านี้ใช้พลังคำนวณมากขึ้นเพื่อแก้ปัญหา แต่ใช้เวลานานกว่าโมเดลปกติ

การพัฒนาโมเดล reasoning เริ่มต้นด้วยการฝึกโมเดลปกติด้วยข้อมูลจำนวนมหาศาล จากนั้นใช้เทคนิค “reinforcement learning” ที่ให้ข้อมูลย้อนกลับเกี่ยวกับการแก้ปัญหาที่ซับซ้อน OpenAI ใช้พลังคำนวณในการฝึก o3 มากกว่า o1 ประมาณ 10 เท่า โดย Epoch เชื่อว่าส่วนใหญ่ใช้กับ reinforcement learning นักวิจัยของ OpenAI เปิดเผยว่าบริษัทวางแผนจะให้ความสำคัญกับ reinforcement learning และใช้พลังคำนวณมากขึ้นกว่าการฝึกโมเดลเบื้องต้น

อย่างไรก็ตาม มีขีดจำกัดสูงสุดของพลังคำนวณที่สามารถใช้กับ reinforcement learning ได้ นักวิเคราะห์อธิบายว่า ผลตอบแทนจากการฝึกโมเดล AI มาตรฐานเพิ่มขึ้น 4 เท่าต่อปี ในขณะที่ reinforcement learning เติบโต 10 เท่าทุกๆ 3-5 เดือน คาดว่าความคืบหน้าของ reasoning training จะ “บรรจบกับขีดจำกัดโดยรวมในปี 2026”

‘https://techcrunch.com/2025/05/12/improvements-in-reasoning-ai-models-may-slow-down-soon-analysis-finds/

Anthropic และ Google ครองชัยชนะ Harvey ลูกค้าสำคัญของ OpenAI

Harvey เครื่องมือ AI สำหรับด้านกฎหมายยอดนิยม ประกาศใช้โมเดลจาก Anthropic และ Google เพิ่มเติมจาก OpenAI ที่ใช้อยู่เดิม สิ่งนี้น่าสนใจเพราะ Harvey เป็นหนึ่งในบริษัทต้นแบบที่ประสบความสำเร็จที่สุดในพอร์ตของ OpenAI Startup Fund ซึ่งเป็นกองทุนที่สนับสนุนบริษัทที่พัฒนาผลิตภัณฑ์บน AI ของ OpenAI

Harvey มีมูลค่า 3 พันล้านดอลลาร์ จากการระดมทุน Series D มูลค่า 300 ล้านดอลลาร์ โดยมี Sequoia เป็นผู้นำ และ GV (กองทุนของ Google) เป็นผู้นำรอบ Series C

Harvey ตัดสินใจขยายนอกเหนือจากโมเดลของ OpenAI หลังจากการทดสอบด้วย BigLaw benchmark พบว่า:

- โมเดลหลากหลายมีประสิทธิภาพดีขึ้นในงานกฎหมายต่างๆ

- แต่ละโมเดลเก่งในงานเฉพาะต่างกัน เช่น Gemini 2.5 Pro เก่งในการร่างเอกสารกฎหมาย แต่ไม่เก่งงานก่อนศาล

Harvey จะเผยแพร่ leaderboard สาธารณะเพื่อจัดอันดับประสิทธิภาพของโมเดลต่างๆ ในงานกฎหมาย

‘https://techcrunch.com/2025/05/13/anthropic-google-score-win-by-nabbing-openai-backed-harvey-as-a-user/

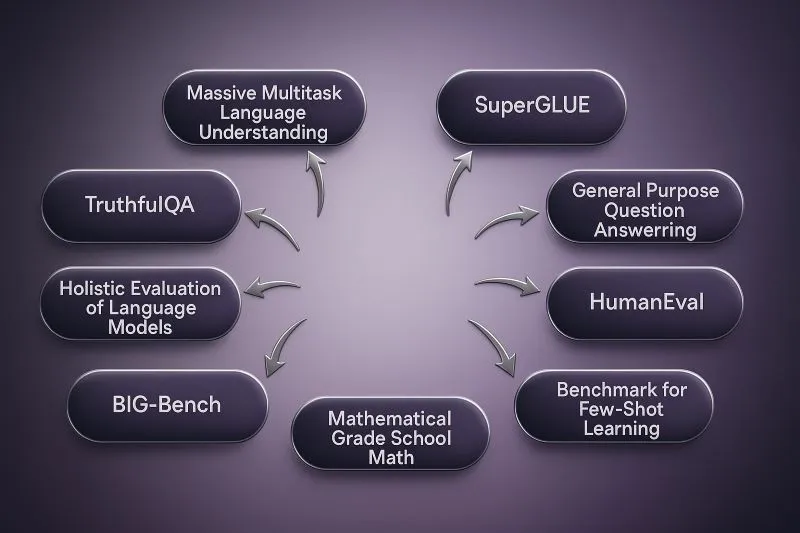

เมื่อเกณฑ์วัดความสามารถ AI เริ่มพัง นักวิจัยเสนอแนวทางใหม่ในการประเมินโมเดล

SWE-Bench ซึ่งเปิดตัวในเดือนพฤศจิกายน 2024 เป็น benchmark ที่ใช้วัดความสามารถของโมเดล AI ในการเขียนโค้ด ด้วยการใช้ปัญหาจริงจาก GitHub (ภาษา Python) กว่า 2,000 ข้อ ได้กลายเป็นมาตรฐานยอดนิยมของบริษัท AI ชั้นนำ เช่น OpenAI, Anthropic และ Google แต่เมื่อเวลาผ่านไป ก็พบว่าโมเดลจำนวนมากถูกออกแบบมาเพื่อ “เอาชนะข้อสอบ” มากกว่าที่จะมีทักษะจริง ส่งผลให้โมเดลที่ได้คะแนนสูงกลับล้มเหลวเมื่อต้องเขียนโค้ดในภาษาอื่น

ปัญหานี้สะท้อนวิกฤตที่ใหญ่กว่าในวงการ AI ซึ่งเรียกว่า “evaluation crisis” หรือวิกฤตการประเมินผล กล่าวคือ benchmark ที่ใช้อยู่ในอุตสาหกรรมจำนวนมาก ไม่ได้วัดผลตามที่ตั้งใจจริง เช่น MMLU, SWE-Bench, หรือ WebArena ซึ่งถูกวิจารณ์ว่าขาดความน่าเชื่อถือ โปร่งใส หรือแม้แต่ถูก “โกง” อย่างไม่เป็นทางการ

นักวิจัยเสนอให้เปลี่ยนแนวทางโดยยึดแนวคิดจากสังคมศาสตร์ คือให้ความสำคัญกับ “validity” หรือความถูกต้องของสิ่งที่ต้องการวัด เช่น การนิยามชัดเจนว่า benchmark วัดทักษะอะไร แยกย่อยเป็นทักษะย่อย และเชื่อมโยงกับงานจริง โครงการอย่าง BetterBench และกลุ่มวิจัยจาก Hugging Face, EleutherAI และมหาวิทยาลัยต่าง ๆ กำลังผลักดันการประเมิน AI แบบใหม่

อย่างไรก็ตาม บริษัท AI ส่วนใหญ่ยังคงใช้ benchmark แบบเดิมที่แม้จะมีปัญหาแต่เข้าใจง่าย และยังสามารถโชว์ความก้าวหน้าทาง “general intelligence” ได้ดีอยู่ นักวิจัยมองว่าต้องเปลี่ยนแนวทาง แม้จะยาก เพราะปัจจุบันโมเดลก้าวหน้าเร็วมากจนทำให้ข้อบกพร่องบางอย่างถูกมองข้าม

‘https://www.technologyreview.com/2025/05/08/1116192/how-to-build-a-better-ai-benchmark/

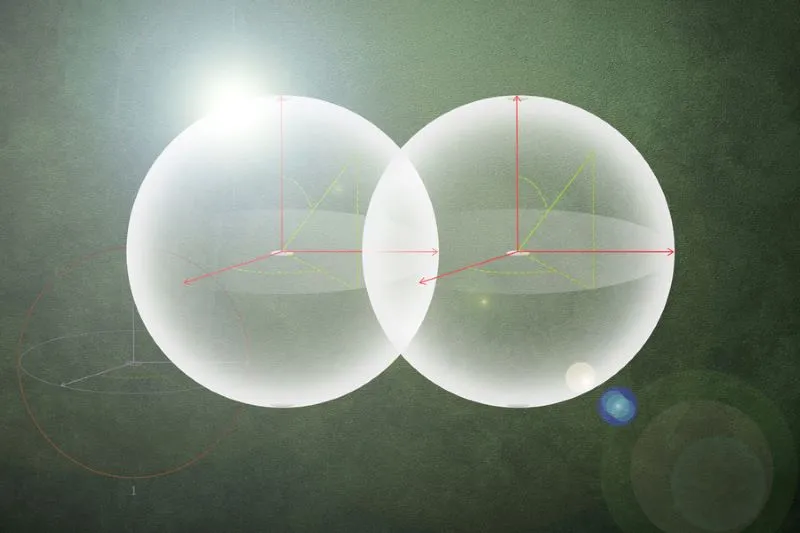

วิศวกร MIT พัฒนาระบบควอนตัมคอมพิวเตอร์ที่ทนทานต่อข้อผิดพลาด

นักวิจัย MIT ประสบความสำเร็จในการสร้างการเชื่อมต่อระหว่างอะตอมเทียมและโฟตอนที่แข็งแกร่งที่สุดเท่าที่เคยมีมาในระบบควอนตัม ซึ่งอาจทำให้อ่านและประมวลผลข้อมูลควอนตัมได้ในเวลาเพียงไม่กี่นาโนวินาที

การวิจัยนี้เป็นก้าวสำคัญสู่คอมพิวเตอร์ควอนตัมที่สามารถทำงานได้เร็วขึ้น โดยใช้สถาปัตยกรรมวงจรยิ่งยวดนำใหม่ที่แสดงการเชื่อมต่อแสง-สสารแบบไม่เชิงเส้นที่แข็งแกร่งกว่าการทดลองก่อนหน้านี้ประมาณ 10 เท่า

การเพิ่มความเร็วในกระบวนการ “อ่าน” (readout) นี้มีความสำคัญต่อความถูกต้องและความเชื่อถือได้ของคอมพิวเตอร์ควอนตัม เนื่องจากต้องวัดผลและแก้ไขข้อผิดพลาดก่อนที่อัตราข้อผิดพลاดจะสะสมขึ้น

หัวหน้างานวิจัย Yufeng “Bright” Ye กล่าวว่า สิ่งนี้จะช่วยขจัดจุดคอขวดหนึ่งในการคำนวณควอนตัม และเร่งให้ถึงระดับควอนตัมคอมพิวเตอร์ที่ทนทานต่อข้อผิดพลาดเร็วขึ้น

งานวิจัยนี้ตีพิมพ์ใน Nature Communications

‘https://news.mit.edu/2025/mit-engineers-advance-toward-fault-tolerant-quantum-computer-0430

ผู้ให้บริการเข้ารหัสพบข้อบกพร่องในการใช้โซลูชั่นเข้ารหัสแบบควอนตัม

DigiCert ผู้ให้บริการเข้ารหัสรายงานว่า องค์กรต่างๆ ยังไม่พร้อมรับมือภัยคุกคามจากควอนตัมคอมพิวเตอร์ แม้ว่ารัฐบาลสหรัฐกำลังเร่งใช้ระบบเข้ารหัสแบบควอนตัม (Post-Quantum Cryptography – PQC) กับระบบของรัฐบาลกลาง

ผลสำรวจพบช่องว่างสำคัญระหว่างความตระหนักรู้และการเตรียมพร้อมจริง:

- 69% ขององค์กรตระหนักถึงความเสี่ยงที่ควอนตัมคอมพิวเตอร์มีต่อมาตรฐานการเข้ารหัส

- แต่มีเพียง 5% ที่นำการเข้ารหัสแบบควอนตัมมาใช้

- 46.4% รายงานว่าข้อมูลที่เข้ารหัสไว้อาจถูกโจมตีได้

ผู้ตอบแบบสำรวจประมาณ 30% คาดว่าต้องใช้เวลา 1-2 ปีในการนำระบบเข้ารหัสแบบควอนตัมมาใช้ และ 33% คาดว่าต้องใช้เวลา 3-5 ปี ซึ่งใกล้เคียงกับเวลาที่พวกเขาคาดว่าคอมพิวเตอร์ควอนตัมจะพัฒนาถึงขั้นที่สามารถถอดรหัสการเข้ารหัสปัจจุบันได้

รัฐบาลไบเดนกำหนดเส้นตายปี 2035 สำหรับหน่วยงานพลเรือนในการนำ PQC มาใช้ แต่ได้เร่งกำหนดเวลาให้ดำเนินการ “เร็วที่สุดเท่าที่เป็นไปได้” ตามคำสั่งด้านไซเบอร์เมื่อวันที่ 16 มกราคม

‘https://insidecybersecurity.com/daily-news/encryption-provider-finds-shortcomings-adoption-post-quantum-cryptography-solutions

สี จิ้นผิง ประกาศพัฒนา AI จีนด้วยพลังแห่ง “การพึ่งพาตนเอง” ท่ามกลางการแข่งขันกับสหรัฐฯ

ฮ่องกง, 26 เมษายน (รอยเตอร์) — ประธานาธิบดีสี จิ้นผิงของจีนให้คำมั่นว่าจะเดินหน้าพัฒนาเทคโนโลยีปัญญาประดิษฐ์ (AI) ด้วยแนวทาง “การพึ่งพาตนเองและการเสริมสร้างความแข็งแกร่งจากภายใน” ตามรายงานของสื่อทางการจีน เมื่อวันเสาร์ที่ผ่านมา ขณะที่จีนกำลังแข่งขันกับสหรัฐฯ ในสนามยุทธศาสตร์สำคัญอย่าง AI

สีได้กล่าวในการประชุมศึกษานโยบายของคณะกรรมการกรมการเมือง (Politburo) เมื่อวันศุกร์ว่า จีนควรใช้ประโยชน์จาก “ระบบแห่งชาติแบบใหม่” ที่รวมทรัพยากรทั้งประเทศเพื่อผลักดันการพัฒนา AI ให้ก้าวหน้า

ผู้เชี่ยวชาญบางรายชี้ว่าช่องว่างด้าน AI ระหว่างจีนกับสหรัฐฯ แคบลงอย่างเห็นได้ชัดในปีที่ผ่านมา โดยเฉพาะหลังจาก DeepSeek สตาร์ทอัพ AI ของจีนเปิดตัวโมเดล reasoning AI เมื่อต้นปี โดยอ้างว่าสามารถพัฒนาได้ด้วยชิปที่ล้ำหน้าน้อยกว่า และต้นทุนต่ำกว่าคู่แข่งจากตะวันตก

จีนยังมีความก้าวหน้าในด้านโครงสร้างพื้นฐานและวิศวกรรมซอฟต์แวร์อย่างต่อเนื่อง สี จิ้นผิงกล่าวว่า “เราต้องเสริมสร้างการวิจัยขั้นพื้นฐาน มุ่งมั่นควบคุมเทคโนโลยีหลัก เช่น ชิปขั้นสูง และซอฟต์แวร์พื้นฐาน เพื่อสร้างระบบฮาร์ดแวร์และซอฟต์แวร์ AI ที่เป็นอิสระ ควบคุมได้ และร่วมมือกันได้”

นอกจากนี้ สียังเน้นย้ำถึงความสำคัญของการเร่งสร้างกฎหมายและระเบียบด้าน AI รวมถึงระบบแจ้งเตือนความเสี่ยงและการตอบสนองฉุกเฉิน เพื่อให้ AI มีความ “ปลอดภัย เชื่อถือได้ และสามารถควบคุมได้”

เมื่อปีที่แล้ว สีเคยกล่าวว่า AI ไม่ควรเป็น “เกมของประเทศร่ำรวยและคนมีทุน” พร้อมเรียกร้องให้เกิดการบริหารจัดการและความร่วมมือระหว่างประเทศในเรื่อง AI

‘https://www.reuters.com/world/china/chinas-xi-calls-self-sufficiency-ai-development-amid-us-rivalry-2025-04-26/